骗2亿!香港最大AI诈骗案超恐怖,罪犯伪造英国高管面容声音开会下令转账,全程毫无破绽(组图)

香港警方最近接到一起涉案金额高达两亿港元(约人民币1.84亿)的诡异诈骗事件,事件中最离谱的是,受骗公司是被AI给空手套了白狼,两亿转出去了一周,才发现事情似乎不对。

(示意图)

反观诈骗者这边,一人分饰多角作案,用AI生成的假人开了个视频会议的时间,就把两亿给拿到手了...

(示意图)

事情曝光后,港媒称其为香港损失最惨重的“变脸”诈骗案,同时它也是首次涉及AI“多人变脸”的诈骗案。经由媒体报道,AI时代的新型诈骗方式,还真看得人背脊发凉...

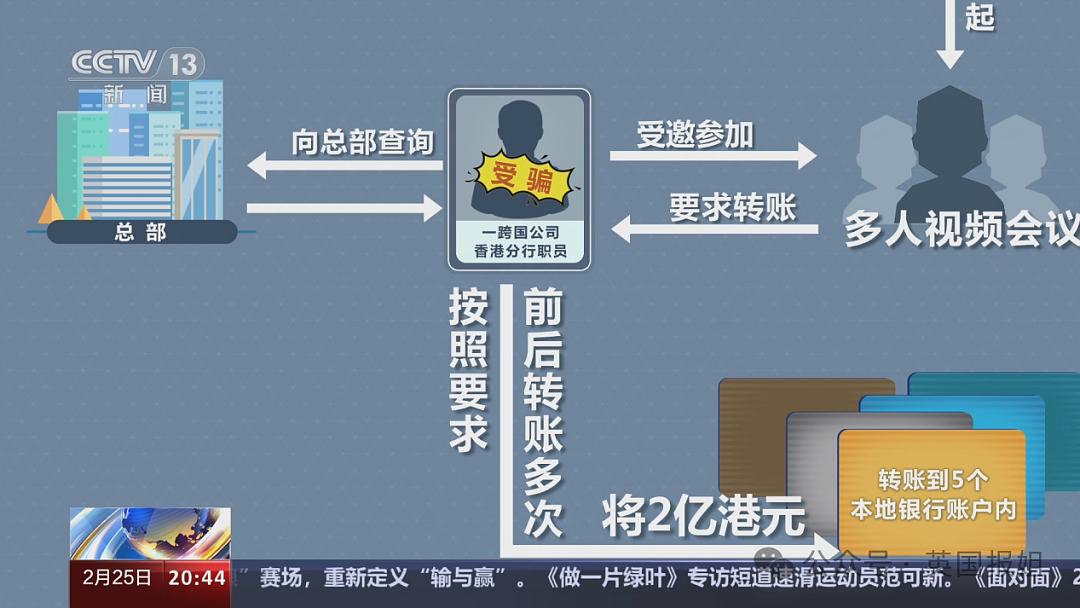

根据香港警方提供的消息,此次事件报案人是某家跨国公司在香港分公司的职员。

1月中旬,香港分公司这边收到英国总部首席财务官的消息,说是要进行一项机密交易。于是,香港团队内部很快组织了视频会议,邀请多名财务部职员参与。

(示意图)

一切都和平时的正常流程无异,职员按照高管们的安排,先后15次将2亿港元转到指定的账户。

但在转账结束后,香港分公司向英国总部询问时,总部人却一头雾水:啊?也没人说让你们给总公司转账啊???

讲清楚前因后果大家才发现,根本就不存在所谓的“机密交易”一事,参与视频会议时大家通过摄像头看到的高管形象,都是用AI制作出来的冒牌货。诈骗人使用以假乱真的视频开了个会,2亿港元竟然就这么轻松到手...

(示意图)

事后调查发现,诈骗人在开始行动前,早就运用强大的搜索能力,把公司在网上的相关公开资料挖了个底朝天。

这些资料包括公司高层的媒体采访、视频平台的相关内容,并且诈骗方很容易就拿到了英国总公司那边高层管理人员的形象和声音,利用Deepfake(深度伪造)技术,制作出高层人员的发言视频。

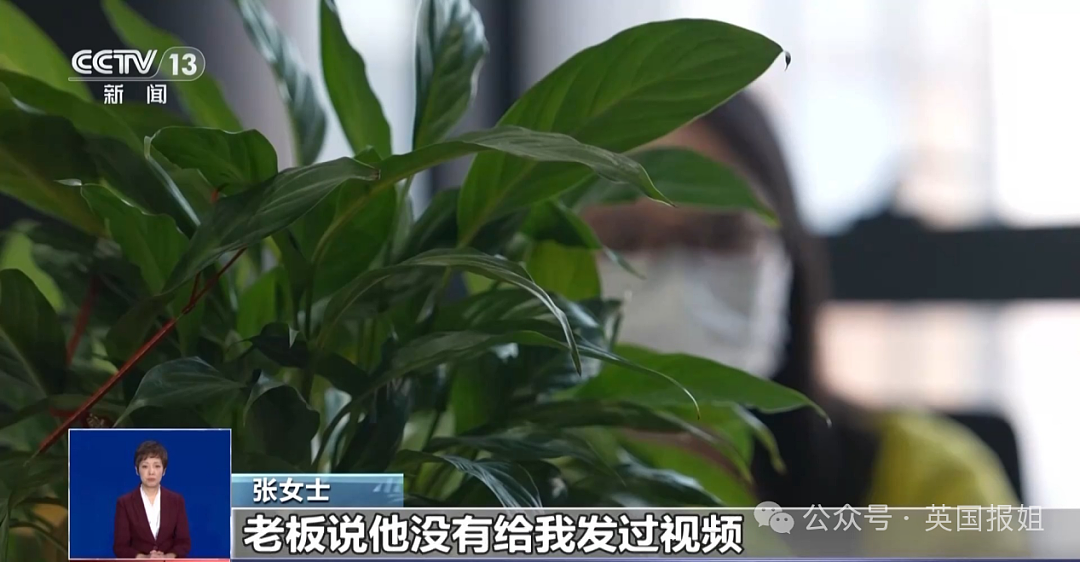

(图源:央视新闻)

诈骗人在视频会议当天直接使用提前制作好的视频,而由于视频会议的内容基本上是总公司的高管们单方面向其他人下达命令,会议期间并没有暴露真相。

职员们眼睁睁看着几位“虚假高管”在镜头里互相讨论、下达命令,于是信以为真,轻轻松松就把账给转了出去...

(示意图)

香港警方表示,目前案件还在调查,现阶段还没有逮捕任何嫌疑人。

卷走2亿港元的诈骗人仿佛凭空出现,完事后又带着巨款人间蒸发...AI新式诈骗的惊天骗局,让看到新闻的读者都觉得有些恐怖,表达了对新技术的担忧:

毕竟谁也没想到,在AI技术大规模落地为普通人所用的前夕,竟然已经有人先在诈骗领域干了一票大的...

不过真要讲起来,此次诈骗事件中的“Deepfake”技术,前几年就已经引起过轰动。

Deepfake指的是“深度伪造技术(简称「深伪技术」)”,是基于AI人工智能技术进行人体图像的合成。目前使用AI的深度学习,深伪技术已经能达到还原度很高的换脸效果,再结合语音伪造技术,就能做到“造人”。

事实上,这项技术打出道起就声名狼藉,早在2019年,有基于该技术的应用APP推出,声称能“一键脱衣”:上传任何女性的照片,再实时生成非正常照片。

而在该技术逐渐应用到视频领域后,大量伪造名人的换脸私密录像出现,并在互联网大范围传播。很多知名女星都成为换脸视频的受害者,但因为类似视频很难追查到源头,维权变得异常艰难。

随着深伪技术的不断“进步”,如今也有人在商业上非法使用Deepfake技术来谋取利益。

比如上个月,霉霉的脸被做进了烤箱的引流广告,视频里“霉霉”亲自出面,说要赠送给粉丝3000套炊具套装。如果有人相信视频中的宣传,点击链接就会自动跳转到家居用品售卖平台。

由此看出,AI发展速度远超想象,爆发性的技术进步会改变每个人的生活,但如今愈演愈烈的AI诈骗风险却不容忽视。

央视新闻报道过类似的诈骗案例,陕西西安财务人员张女士与老板视频通话,老板要求她转账186万元到一个指定账号。因为老板明确表示非常着急,加上声音还有视频都跟老板本人一模一样,张女士直接按照要求把钱转了过去。

转账之后,张女士按照规定将电子凭证发到了公司财务内部群里,出乎意料的是,群里的老板看到信息后,向她询问这笔资金的来由。

张女士报警求助后,警方立刻对接反诈中心、联系相关银行进行紧急止付,这才保住了大部分的被骗资金。

面对AI诈骗的入侵,国内已经发布过AI反诈宣传片。去年年底的一段反诈宣传片中,母亲和远隔万里的女儿视频通话,得知女儿需要钱后,准备马上就把一万五打过去。

此时门铃一响,氛围顿时变得有些恐怖。本该远隔万里的女儿,却突然出现在家门口。

片尾谜底揭晓,大家才发现,视频中的“女儿”只是AI制造出的假象。“AI女儿”和真人的面容与声音完全相同,科幻片中的惊悚桥段当场成真。

不少网友当时就表示看到头皮发麻,谁能想到, AI运用到诈骗上,会产生如此恐怖的结果。

再回到在香港发生的案子,2亿规模的案子已经昭示着,大规模、大金额的AI诈骗离我们不再遥远。或许不久的未来,普通人也需要像防范电信诈骗那般,防范身边各种形式的AI诈骗。

(图源:@央视新闻)

针对此次2亿港元AI诈骗事件,香港警方提出了一些有效的防范措施:

- 如果觉得聊天内容不太对劲,可以放大窗口查看光线和阴影是否正常,人像边缘有没有模糊。

- 一些AI视频是提前录制好的,可以要求对方做出点头等即时动作,观察对方的实时反应。

- 提问一些只有你和对方知道的私人问题或是家庭问题,来进一步核实身份。

- 警惕任何亲友提出的“打钱”要求。

- 小心、谨慎使用面部识别的授权。

(示意图)

“眼见不一定为实”、“有图有视频也不一定是真相”的时代已经来临,普通人今后可能会受到难以想象的冲击。

技术更新已经催生了更多、更复杂的诈骗手段,对我们普通人来说,提前了解才能有心防范。也希望能有打击AI诈骗的技术早日普及,毕竟新技术出现的初衷,本该是让我们过上更美好的生活。

+61

+61 +86

+86 +886

+886 +852

+852 +853

+853 +64

+64